Commonsense Prototype for Outdoor Unsupervised 3D Object Detection (CVPR 2024)

摘要

无监督三维目标检测的主流方法是基于聚类的伪标签生成和迭代自训练过程。然而,由于激光雷达扫描的稀疏性,会导致尺寸和位置错误的伪标签,从而导致检测性能低于标准。为了解决这个问题,本文介绍了一种基于常识原型的检测器,称为CPD,用于无监督的3D物体检测。CPD首先基于常识性直觉,构建具有高质量边界框和密集点特征的常识性原型(CProto)。随后,CPD通过利用CProto先前的大小来细化低质量的伪标签。此外,CPD还利用CProto的几何知识提高了稀疏扫描目标的检测精度。在Waymo开放数据集(WOD)、PandaSet和KITTI数据集上,CPD的性能远远超过最先进的无监督3D探测器。此外,通过对CPD在WOD上的训练和在KITTI上的测试,CPD在简单和中等车型上的3D平均精度分别达到了90.85%和81.01%。这些成就使CPD接近于完全监督检测器,突出了我们方法的重要性。

1. 引言

自动驾驶需要在城市场景中可靠地检测3D物体(例如车辆和骑自行车的人),以便进行安全的路径规划和导航。由于神经网络的强大功能,许多研究已经通过完全监督的方法开发出高性能的3D探测器[4,15,30 - 33]。然而,这些模型在很大程度上依赖于来自不同场景的人工注释,以保证它们在不同场景中的有效性。这种数据标注过程通常既费力又耗时,限制了检测器在实践中的广泛部署[40]。

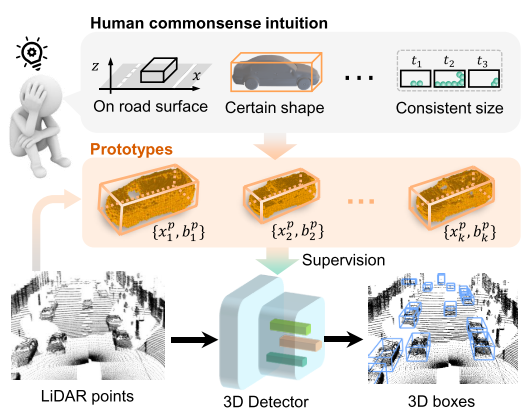

一些研究已经探索了通过弱监督学习减少标注需求的方法[3,26,46],将标注成本降低了80%以上。值得注意的是,3D场景中的物体具有可区分的属性,可以通过一定的常识推理轻松识别(见图1)。例如,物体通常位于具有一定形状的地面上;对象大小在不同帧之间是固定的。这一见解促使我们开发了一种无监督的3D探测器,无需人工注释即可运行。

近年来,传统方法利用地面去除[9]和聚类技术[42]进行无监督三维目标检测。然而,由于3D场景中物体的稀疏性和遮挡,这些方法往往难以达到令人满意的性能。先进的方法通过聚类从点云序列中创建初始伪标签,并通过迭代训练深度网络来引导一个好的检测器[41]。然而,激光雷达扫描的稀疏性和视域限制导致伪标签的大小和位置不准确,误导网络收敛,导致检测性能不佳。一个对象的子集,记作完全对象T,受益于至少对整个点云序列进行一次完整扫描,允许通过时间一致性对其伪标签进行细化[41]见图2 (a)。然而,大多数物体(如图2 (c)所示,WOD上的65%[25])被称为不完整物体J,缺乏完整的扫描覆盖(见图2 (b)),无法通过时间一致性恢复。

9:Fast segmentation of 3D point clouds for ground vehicles

41:Towards unsupervised object detection from lidar point clouds

42:Unsupervised 3d category discovery and point labeling from a large urban environment

![图2。WOD[25]验证集上完整和不完整对象的说明和统计(大到足以展示一般问题)。(a)利用时间一致性改进完整对象T的伪标签。(b)不完整对象J的伪标签无法通过时间一致性进行细化。(c) 65%的对象缺乏完整的扫描覆盖,产生不准确的伪标签(Max IoU(交集超过联合)与GT(地面真值)< 0.5)。(d)完整物体GTT和不完整物体GTJ的整车GT具有相似的尺寸分布。(e)完整对象PseT和不完整对象PseJ的伪标号大小分布不同。(f)(g)附近的静止物体在连续帧中具有高的完备性。](/pic/unsup2.png)

为了解决这个问题,本文提出了一种基于常识原型的检测器,称为CPD,用于无监督的3D物体检测。CPD建立在两个关键见解之上:(1)类内对象的基本真理在不完整对象和完整对象之间保持相似的大小(长度、宽度和高度)分布(见图2 (d))。(2)附近的静止物体在连续帧中非常完整,可以通过常识直觉准确识别(见图2 (f)(g))。我们的想法是从完整的物体中构建一个表示精确几何形状和尺寸的常识原型(Commonsense Prototype, CProto)集,以改进不完整物体的伪标签,提高检测精度。为此,我们首先设计了一种无监督的多帧聚类(MFC)方法,该方法产生高召回率的初始伪标签。随后,我们引入了一个无监督的完整性和大小相似度(CSS)评分,该评分选择高质量的标签来构建CProto集。此外,我们设计了一种CProto约束盒正则化(CBR)方法,通过结合CProto的尺寸先验来改进伪标签。此外,我们开发了CProto约束自我训练(CST),利用CProto的几何知识提高稀疏扫描目标的检测精度。

通过在广泛使用的WOD[25]、PandaSet[35]和KITTI数据集[6]上的实验验证了我们设计的有效性。此外,我们设计的各个组件也在WOD上进行了大量的实验验证[25]。这项工作的主要贡献包括:

- 我们提出了一种基于常识原型的检测器(CPD)用于无监督的3D物体检测。CPD比最先进的无监督3D探测器要好得多。

- 提出了基于多帧聚类(MFC)和CProto约束盒正则化(CBR)的伪标签生成和细化方法,极大地提高了伪标签的查全率和查准率。

- 我们提出CProto约束盒自训练 (CST)用于无监督3D检测。提高了稀疏目标的识别和定位精度,显著提高了检测性能。

2. 相关工作

完全/弱监督3D对象检测。最近的全监督3D检测器构建了单阶段[8,10,27,39,48,49]、两阶段[4,20 - 22,31 - 33,37]或多阶段[2,30]的深度网络用于3D目标检测。然而,这些方法严重依赖于大量精确的注释。一些弱监督方法用低成本的点击标注代替方框标注[17]。其他方法通过只注释部分场景[3,26,45,46]或部分实例[34]来减少监督。与上述所有工作不同,我们的目标是设计一个不需要人类级别注释的3D检测器。

无监督的3D物体检测。以前的无监督预训练方法通过屏蔽标签[36]或对比损失[14,38]来识别未标记数据中的潜在模式。但这些方法需要人工标记来进行微调。传统方法[1,19,24]采用地面去除和聚类方法进行三维目标检测,无需人工标记,但检测性能较差。一些基于深度学习的方法通过聚类生成伪标签,并使用伪标签迭代地训练3D检测器[40]。最近的OYSTER[41]通过时间一致性提高了伪标签质量。然而,大多数不完整对象的伪标签不能通过时间一致性来恢复。我们的CPD通过利用CProto的几何先验来改进伪标签并指导网络收敛,从而解决了这个问题。

基于原型的方法。基于原型的方法被广泛应用于二维检测中[11,12,16,29,44]。受这些方法的启发,Prototypical VoteNet[47]构建了从基本类中学习的几何原型,用于少镜头3D物体检测。GPA-3D[13]和CL3D[18]从源域模型构建几何原型,用于域自适应三维检测。然而,从基本类学习和源域上的训练都需要高质量的注释。与此不同的是,我们使用常识性知识构建CProto,并在没有人类级别注释的情况下以zero-shot方式检测3D对象。

3. CPD方法

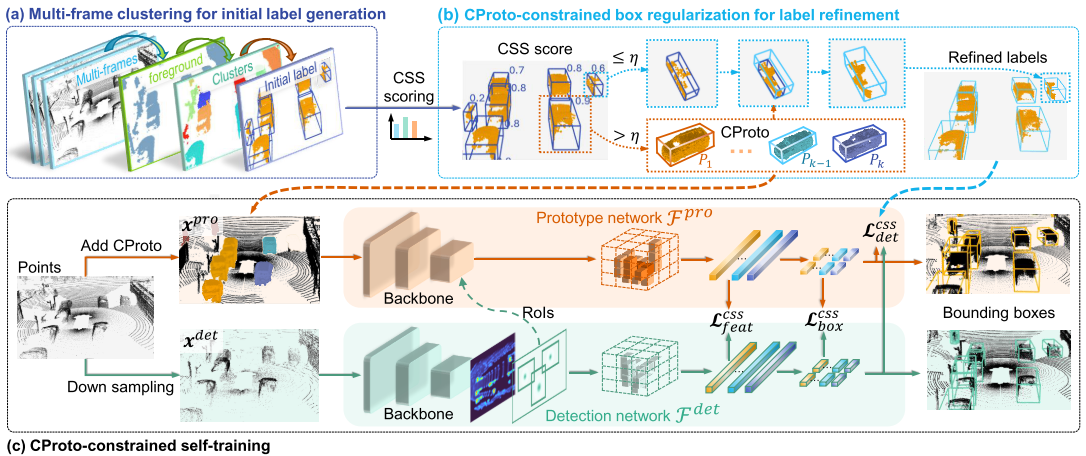

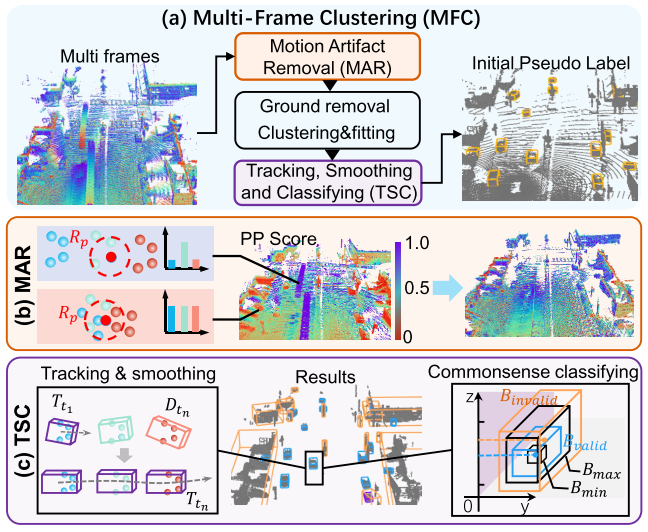

本文介绍了基于常识原型的检测器(CPD),这是一种用于无监督三维物体检测的新方法。如图3所示,CPD主要由三个部分组成:(1)初始标签生成;(2)标签细化;(3)自我训练。我们详细设计如下。

3.1. 初始标签生成

最近的无监督方法[40,41]以一种与类别无关的方式检测3D物体。如何在没有标注的情况下对物体(如车辆和行人)进行分类仍然是一个未解决的挑战。我们的观察表明,连续帧中的一些静止物体看起来更完整(见图2 (f)),并且可以通过预定义的大小进行分类。这促使我们设计了一种多帧聚类(MFC)方法来生成初始标签。MFC包括运动伪影去除、聚类和后处理。

40:Learning to Detect Mobile Objects from LiDAR Scans Without Labels

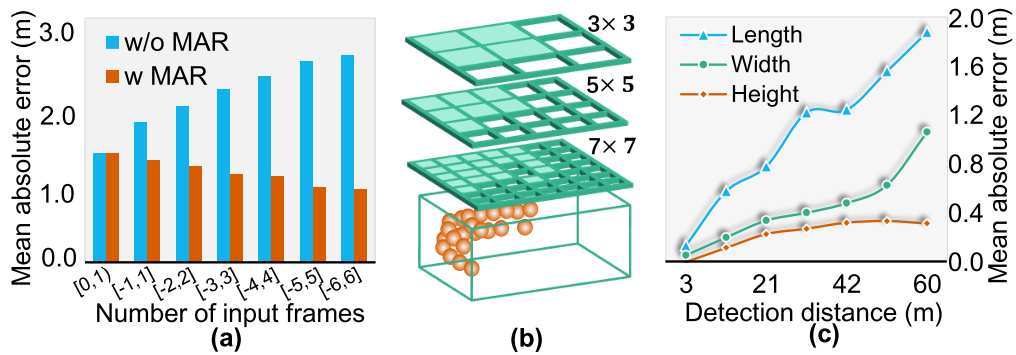

**运动伪影去除(MAR)**。直接变换和连接2n+1个连续帧{x−n,…, xn}(即过去n,未来n和当前帧)到单个点云x * 0引入运动物体的运动伪影,导致随着n的增长标签误差增加(见图4(a))。为了缓解这个问题,我们首先将连续帧转换为全局系统,并计算连续帧的持续点分数(PPScore)[40]来识别运动中的点。我们保留x0中的所有点,并删除其他帧x - n中的移动点,…, x−1,x1,…在此移除之后,我们连接帧以获得密集点x * 0。

聚类和后处理。根据最近的研究[41],我们在x∗0上应用ground removal[9], DBSCAN[5]和bounding box fitting[43]来获得一组与类别无关的边界框(bounding box)b。我们观察到,同一类的对象在三维空间中通常具有相似的大小。因此,我们根据人类的常识预先定义了特定类别的尺寸阈值(例如,车辆的长度一般大于0.5m),将b分类为不同的类别。然后,我们应用类别无关跟踪将小背景对象与前景轨迹关联起来,并通过使用时间相干性来增强对象大小的一致性[41]。此过程得到一组初始伪标签b = {bj}j,其中bj = [x, y, z, l, w, h, α, β, τ]分别代表位置、宽度、长度、高度、方位角、类恒等式和跟踪恒等式。

5:A density-based algorithm for discovering clusters in large spatial databases with noise

43:Efficient l-shape fitting for vehicle detection using laser scanners

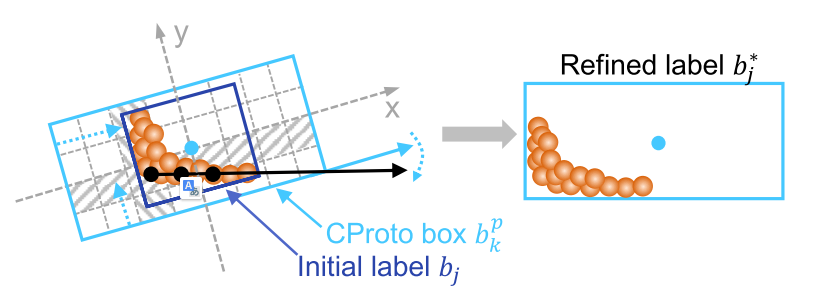

3.2. 标签细化的原型约束盒正则化

如第1节所述,不完整对象的初始标签通常在大小和位置上不准确。为了解决这个问题,我们引入了CProto-constrained Box Regularization (CBR)方法。其核心思想是构建一个基于无监督评分的高质量CProto集,以完善不完整对象的伪标签。与OYSTER[41]只能细化至少一次完整扫描的目标的伪标签不同,我们的CBR可以细化所有目标的伪标签,显著降低了整体尺寸和位置误差。

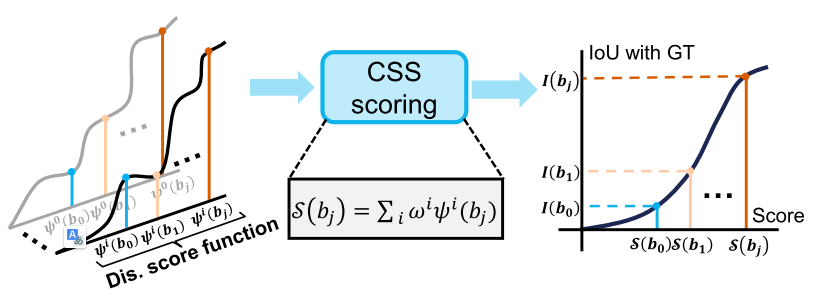

完整性和大小相似性(CSS)评分。现有的标签评分方法,如IoU评分[21]是为完全监督检测器设计的。相反,我们引入了一种无监督的完备性和大小相似性评分(CSS)方法。它旨在仅使用常识性知识来近似IoU分数(见图5)。

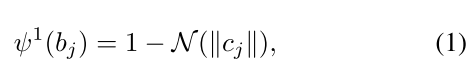

距离得分。CSS首先根据距离评估对象的完整性,假设离自我车辆更近的标签可能更准确。对于初始标签bj,我们在[0,1]范围内归一化到自我车辆的距离,以计算距离得分为:

其中N是归一化函数,cj是bj的位置。然而,这种基于距离的方法有其局限性。例如,靠近自我车辆的遮挡物体,本应获得较低的分数,但由于它们距离较近,无意中被分配了较高的分数。为了缓解这一问题,我们引入了多层次占用(MLO)评分,如图4 (b)所示。

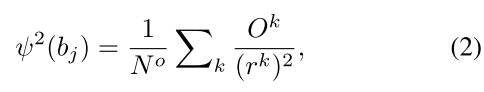

MLO分数。考虑到物体的大小不同,我们将初始标签的边界框划分为多个具有不同长度和宽度分辨率的网格。然后通过确定聚类点占用的网格比例来计算MLO分数:

式中No为分辨率号,Ok为第k个分辨率下占用的网格数,rk为第k个分辨率下的网格号。

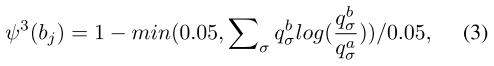

尺寸相似度(SS)得分。虽然距离和MLO分数可以有效地评估定位和大小质量,但它们在评估分类质量方面存在不足。为了弥补这一差距,我们引入了SS分数。这个分数使用一个类特定的模板框a (Wikipedia中典型对象的平均大小),并计算截断的KL散度[7]。请注意,这个分数是由比率差异决定的,而不是它们的具体值。l、w、h比率的简单常识(车辆2:1:1,行人1:1:2,骑自行车者2:1:2)也可以用在这里。

式中qa σ∈{la, wa, ha}, qb σ∈{lb, wb, hb}为模板和标签的归一化长、宽、高。

我们将三个指标S(bj) = pi ωiψi(bj)线性组合以产生最终得分,其中ωi是权重因子(在本研究中我们采用简单平均值,ωi = 1/3)。对于每个bj∈b,我们计算其CSS分数scss j = S(bj),得到分数S = {scss j}j的集合。

CProto集合构造。常规的基于原型的可学习方法需要标注[13,47],这在无监督问题中是不可用的。我们构建了一个高质量的CProto集合P = {Pk}k,表示基于无监督CSS分数的几何和大小中心。式中,Pk = {xp k, bp k},其中xp k表示内部点,bp k表示边界框。具体来说,我们首先根据初始标签b的跟踪身份τ将其分类为不同的组。在每一组中,我们选择符合高CSS评分阈值η(在验证集上确定,本研究中使用0.8)的高质量框和内部点。然后,我们将所有的点和盒子转换成一个局部坐标系,通过对高质量盒子进行平均得到xp k,通过将所有的点串联得到bp k。

盒子正规化。接下来,我们根据CProto的大小对初始标签进行正则化。根据WOD验证集的统计[25],我们观察到初始标签的高度相对于长度和宽度是相对正确的(见图4 (c))。直观地看,类内具有相同高度的3D对象具有相似的长度和宽度。因此,我们将初始标签bj与CProto Pk通过最小盒高差进行关联。初始的伪标签具有相同的Pk和相似的长度和宽度,自然会被归为同一组。然后,我们对每个组执行调整大小和重新定位,以改进伪标签。

- (1)改变形状。我们直接用bp k∈Pk的长、宽、高来替换bj的大小。

- (2)重新定位。由于点大多在物体的表面和边界上,我们将物体划分为不同的箱,并将箱的边界和方向与最密集部分的边界点对齐(见图6)。最后,我们得到改进的伪标签b∗= {b∗j}j。

3.3. CProto约束自我训练(CST)

最近的方法[40,41]利用伪标签来训练三维检测器。然而,即使经过改进,一些伪标签仍然不准确,降低了正确监督的有效性,并可能误导培训过程。为了解决这些问题,我们提出了两种设计:(1)css加权检测损失,它根据标签质量分配不同的训练权值,以抑制虚假监督信号。(2)几何对比度损失,将稀疏扫描点的预测与密集CProto对齐,从而提高特征一致性。

网络体系结构。我们采用密集稀疏对齐架构(图3 (c)),由原型网络Fpro和检测网络Fdet组成,由两级CenterPoint构建[39]。在训练过程中,我们将每个b * j对应的点xp k从CProto Pk添加到场景中,得到密集的点云xpro。我们将xpro馈送到Fpro,以产生相对较好的特征和检测。然后我们将随机下采样点xdet作为稀疏样本馈送到Fdet。我们通过检测损失和对比度损失对两个分支的特征和检测进行对齐。在测试过程中,我们将没有下采样的点馈送到检测网络Fdet进行检测。

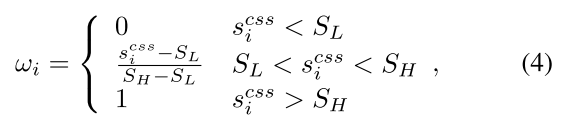

CSS的权重。考虑到虚假的伪标签可能会误导网络收敛,我们首先根据不同的标签质量计算一个损失权值。形式上,我们将伪标签的CSS分数sssi转换为:

其中SH和SL是高/低质量阈值(我们根据经验分别设置0.7和0.4)。

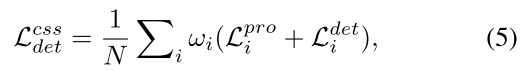

css加权检测损失。为了减少假标签的影响,我们制定了css加权检测损失来细化N个提案:

式中Lpro i和Ldet i分别为Fpro和Fdet的检测损耗[4]。损失由伪标签b *和网络预测计算。

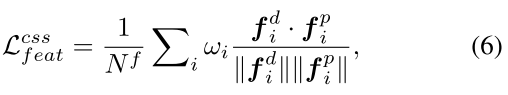

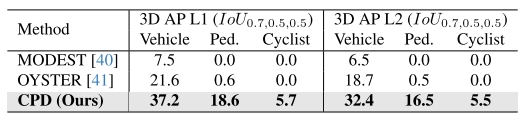

几何对比度损失。我们制定了两种对比度损失,以最小化原型和检测网络之间的特征和预测盒差。(1)特征对比度损失。对于检测网络中的前景RoI ri,我们通过体素集抽象[4]从原型网络中提取特征fp i,从检测网络中提取特征fd i。然后我们用余弦距离表示对比度损失:

其中Nf为前景提案号。(2)箱体对比度损失。对于来自原型网络的盒状预测dp i和来自检测网络的盒状预测dd i。然后通过IoU、位置差、角度差来计算箱体对比度损失:

表示IoU函数;CD I, α d1 I为dd I的位置和角度;Cp I, α p1为dp I的位置和角度。我们终于把所有的损失归结为训练探测器。

4. 实验

4.1. 数据集

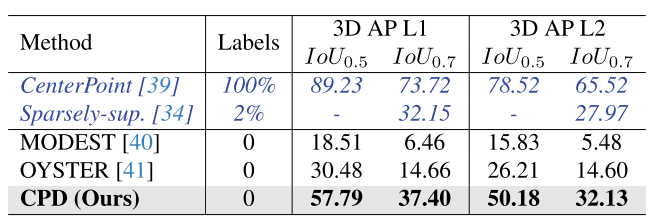

Waymo开放数据集(WOD)。由于场景的多样性,我们对其进行了大量的实验[25]。WOD包含798、202和150个序列,分别用于训练、验证和测试。我们采用了类似的指标(3D AP L1和L2)作为完全/弱监督方法[31,34]。没有使用注释进行训练。

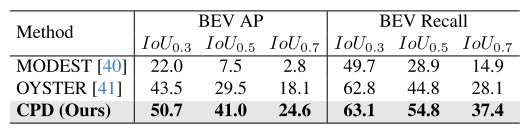

PandaSet数据集。为了与最近的无监督方法[41]进行比较,我们还在PandaSet上进行了实验[35]。像[41]一样,我们将数据集分成73个训练片段和30个验证片段,并使用与类别无关的BEV AP和召回指标,阈值分别为0.3、0.5和0.7 IoU。

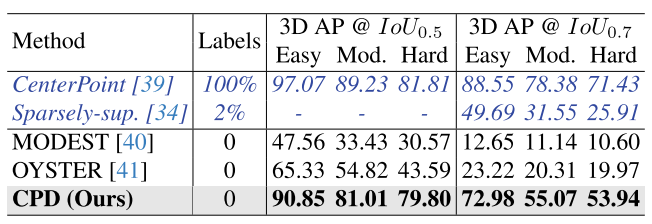

KITTI数据集。由于KITTI检测数据集[6]没有提供连续帧,我们只在3769 val分割[4]上测试了我们的方法。我们使用了与完全/弱监督方法类似的指标(具有0.5和0.7 IoU阈值的Car 3D AP R40)[32,34]。

4.2. 实现细节

网络的细节。原型网络和检测网络都采用了与CenterPoint[39]相同的三维主干,与Voxel-RCNN[4]相同的RoI细化网络。对于WOD和KITTI数据集,我们使用与CenterPoint相同的检测范围和体素大小[39]。对于Pandaset,我们使用与OYSTER相同的检测距离[41]。

训练的细节。我们采用了广泛使用的全局缩放和旋转数据增强。我们使用ADAM优化器在8个Tesla V100 gpu上训练我们的网络。我们使用一个周期学习率策略的学习率为0.003。我们训练了CPD20个epoch。

4.3. 与无监督检测器的比较

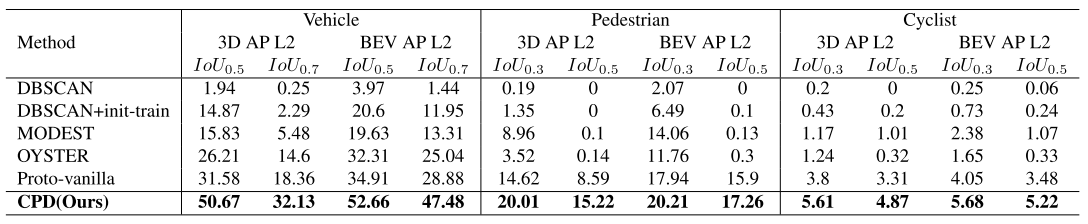

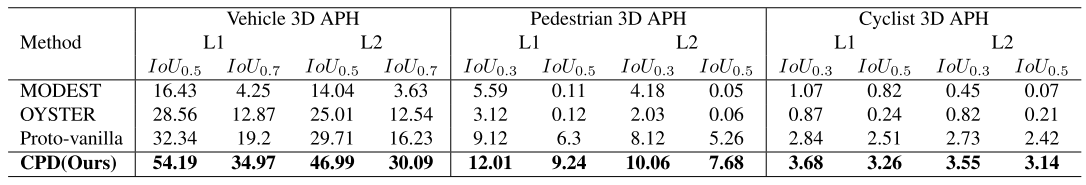

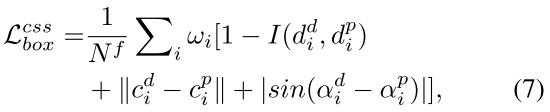

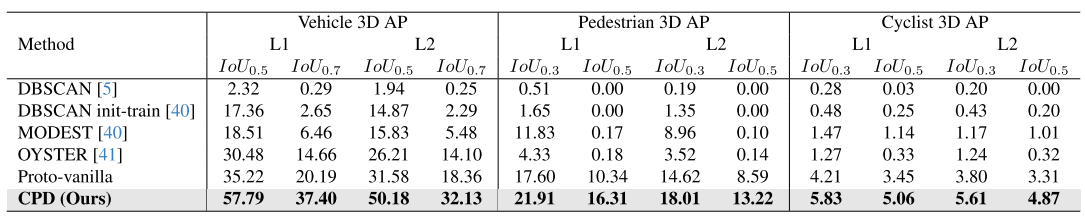

WOD结果。WOD验证集和测试集的结果如表1和表2所示。所有方法都使用相同大小的阈值来定义对象类,并使用单遍历。我们的方法明显优于现有的无监督方法。值得注意的是,在IoU阈值为0.7、0.5和0.5的3D AP L2下,我们的CPD在车辆、行人和骑自行车者方面分别比OYSTER[41]高出18.03%、13.08%和4.55%。这些进步来自于我们的MFC, CBR和CST设计,这些设计产生了卓越的伪标签和提高的检测精度。CPD也超越了使用类特定原型的prototo -vanilla方法[23]。

PandaSet上的结果。在PandaSet上分类无关的结果如表3所示。在0.7 IoU阈值下,我们的方法优于OYSTER 6.5%的AP和9.3%的召回率。这一改进很大程度上是由于我们的CPD提高了标签质量。与OYSTER不同,OYSTER在训练过程中会受到虚假标签的误导影响,我们的CPD利用CProto的先验大小来显著改善这些标签。

4.4. 与完全/弱监督检测器的比较

KITTI数据集上的结果。为了进一步验证我们的方法,我们在WOD上预训练了我们的CPD,以及OYSTER[41]和MODEST[40],并使用统计归一化(SN)在KITTI数据集上进行了测试[28]。汽车检测结果如表4所示。我们首先将我们的方法与稀疏监督方法(带有2%标签的弱监督方法)[34]进行比较,稀疏监督方法每帧注释一个实例进行训练。我们的无监督CPD在中等车型上的性能比这种稀疏监督方法高出23.52% 3D AP@ IoU0.7。此外,我们的方法在0.5 IoU阈值下实现了简单和中等汽车类别的90.85%和81.01%的3D AP。值得注意的是,这一性能与完全监督方法CenterPoint[39]相当,证明了我们方法的先进性。

WOD结果。我们还将我们的方法与WOD验证集上的完全/弱监督方法进行了比较[25]。车辆检测结果如表5所示。我们的无监督CPD在3D AP L1和L2方面分别比稀疏监督方法(2%注释)高5.25%和4.16%。

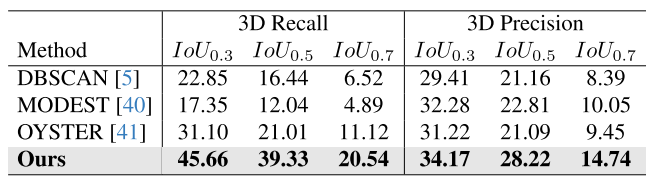

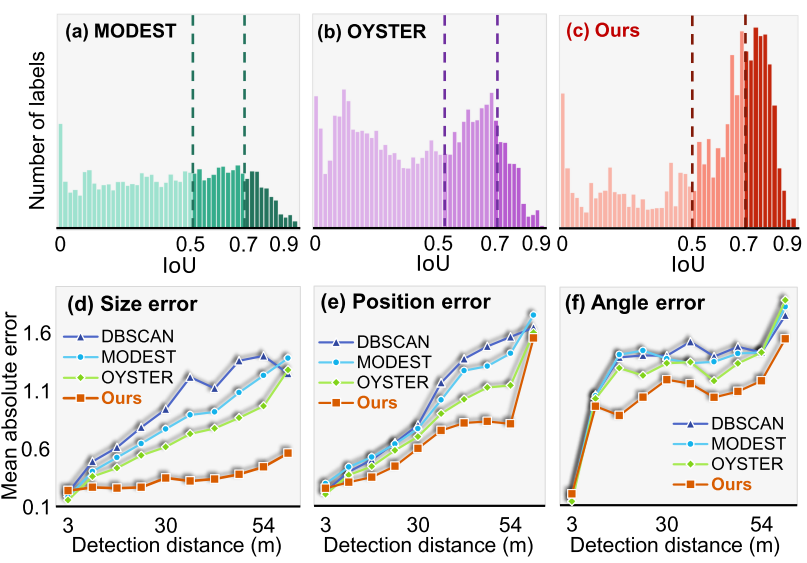

4.5. 伪标签比较

为了验证我们的伪标签,我们在WOD验证集上分析了它们的3D召回率和精度。如表6所示,我们的方法以9.42%的召回率和5.29%的精度提高(在0.7 IoU阈值下)超过了之前表现最好的OYSTER。为了了解这种改进的来源,我们检查了伪标签和基础真值之间的IoU,并比较了图7 (a)(b)(c)中的IoU分布。我们还在图7 (d)(e)(f)中给出了不同伪标签之间的大小、位置和角度的平均绝对误差。该方法的IoU分布比其他方法更接近于1,并且在大小、位置和角度上的误差也更小。这些结果验证了我们的MFC和CBR显著减少了标签错误。

4.6. 消融实验

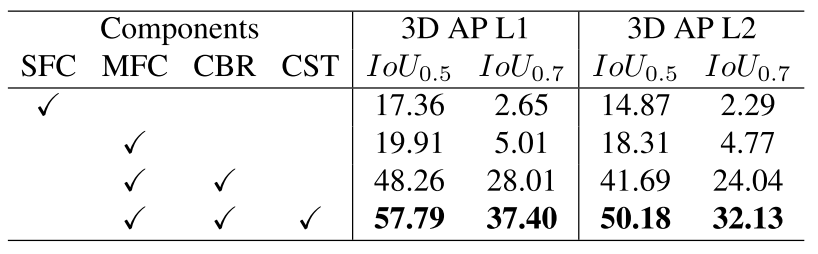

CPD的成分分析。为了评估我们设计的单个贡献,我们逐步添加每个组件,并使用WOD验证集评估它们对车辆检测的影响。结果如表7所示。我们的MFC方法在AP中比单帧聚类(SFC)方法高出2.52%,这归因于与单帧相比,跨连续帧的对象的点表示更完整。CBR在AP中进一步提高了19.27%的性能,因为它减少了伪标签的大小和位置错误。CST对AP的贡献增加了8.09%,证明了CProto的几何特征在检测稀疏目标方面的有效性。

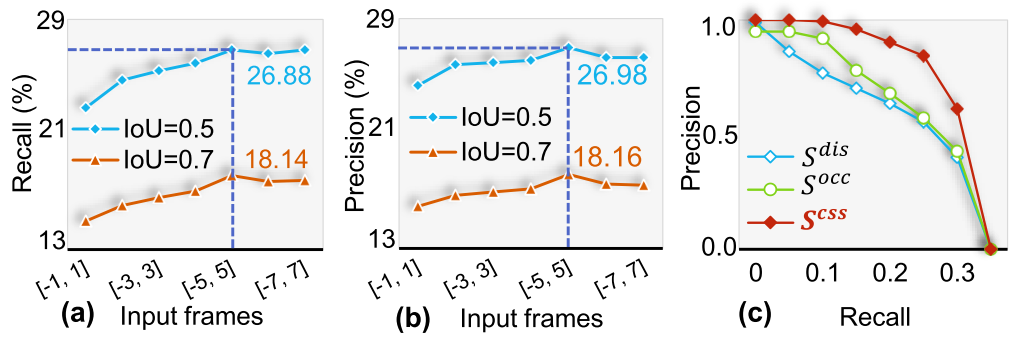

mfc的帧数。为了检验帧数对初始伪标签质量的影响,我们在WOD验证集上实验了不同数量的过去和未来点云帧。图8 (a)(b)所示的BEV结果表明,在[- 5,5]帧(5个过去帧、5个未来帧和当前帧)下,性能最佳。额外的帧并没有显著提高记忆的回忆率和准确率。因此,我们在本研究中使用了11帧作为初始伪标签生成。

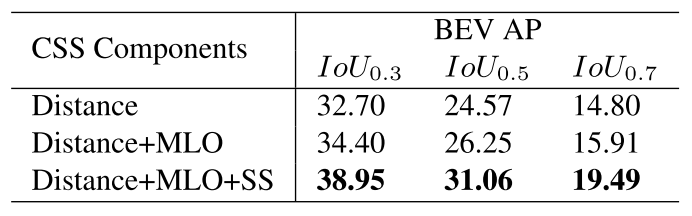

CSS评分的成分分析。为了评估评分系统的有效性,我们计算了不同分数的初始伪标签的BEV AP。表8中报告的标签数量平均绝对误差Precision Recall (%) Precision(%)评估显示,结合所有成分(距离、MLO和SS)产生最高的AP。图8 (c)中绘制的Recall - Precision曲线也支持这一发现。这表明了各成分在准确测量伪标签质量中的重要性。

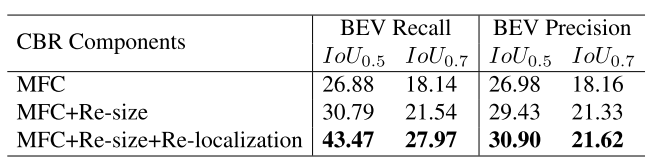

CBR的成分分析。为了评估调整尺寸和重新定位对CBR的影响,我们进行了实验并分析了伪标签的性能。如表9所示,在0.5 IoU和0.7 IoU阈值下,重新调整尺寸导致BEV召回率分别增加3.91%和3.4%;在这些阈值下,重新定位进一步提高了召回率12.68%和6.43%,同时也提高了准确率。这些结果表明了这两个成分的重要性,从而有效地改进了伪标签。

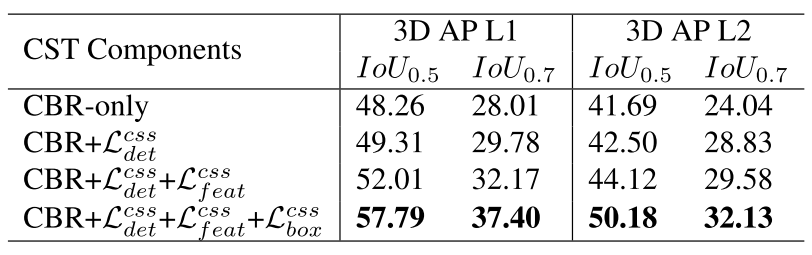

CST的成分分析。为了评估CST中每个成分的有效性,我们仅使用cbr生成的伪标签建立了一个基线,用于训练两阶段CenterPoint检测器,然后逐渐添加我们的损失成分,并在WOD验证集上评估车辆检测性能。如表10所示,所有损耗成分都有助于提高性能。具体来说,我们的Lcss det使用CSS权重减轻了虚假伪标签的影响,并将IoU0.7的3D AP L2提高了4.79%。通过利用密集CProto的几何知识进行更有效的稀疏目标检测,我们的Lcss技术和Lcss盒分别将IoU0.7的3D AP L2提高了0.75%和2.55%。

4.7. 可视化的比较

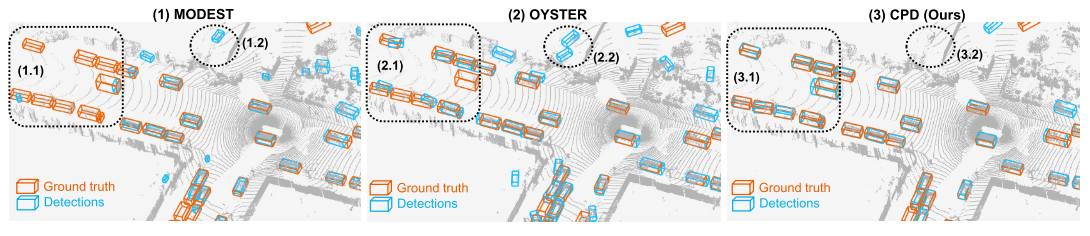

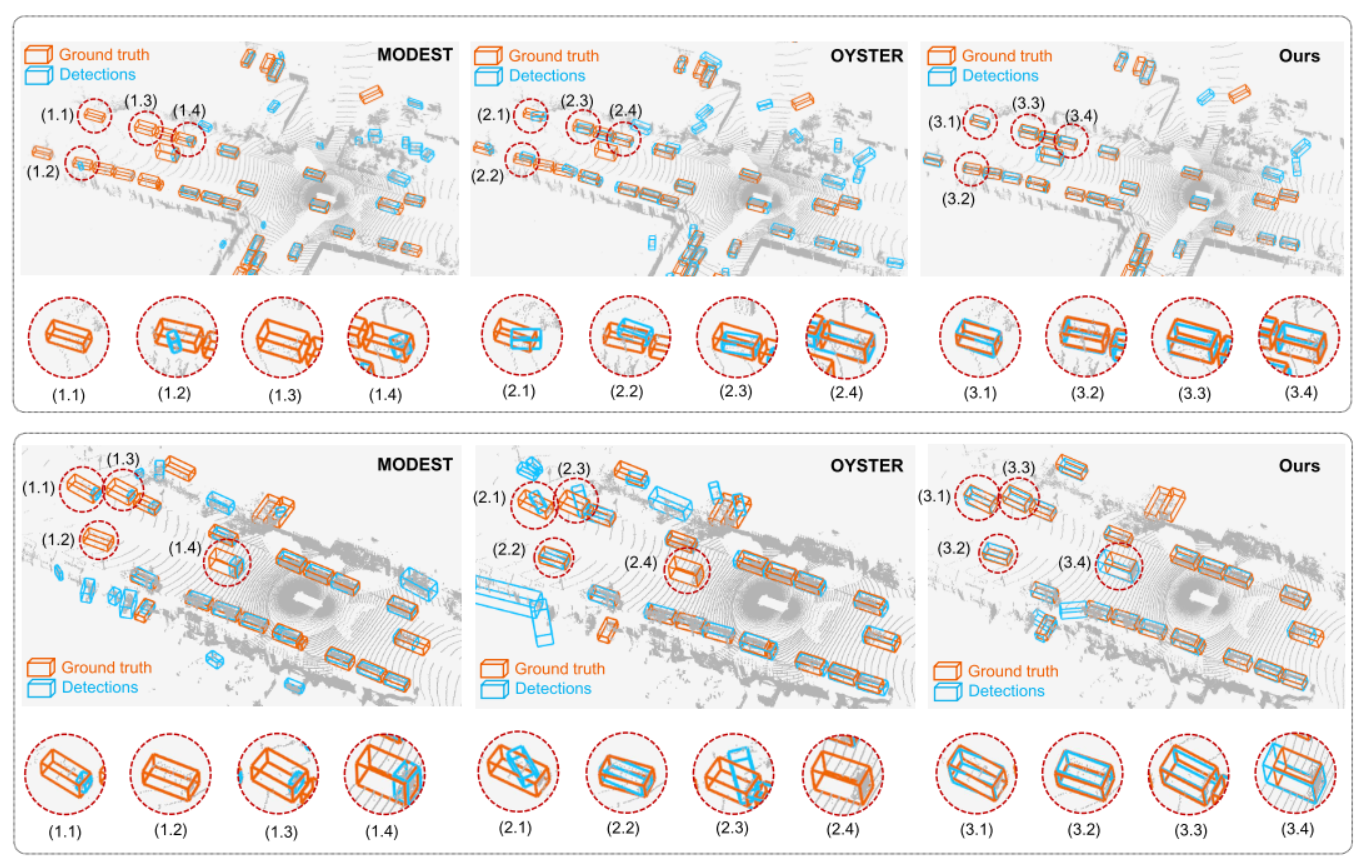

为了更直观地理解我们的方法是如何提高检测性能的,我们将我们的结果与MODEST[40]和OYSTER[41]进行了视觉比较,如图9所示。MODEST经常遗漏远处的、稀疏的物体(图9(1.1)),而OYSTER检测到它们,但不准确地报告它们的大小和位置(图9(2.1))。相比之下,CPD使用我们基于cproto的设计,不仅可以识别这些物体,还可以准确地预测它们的大小和位置(图9(3.1))。此外,由于我们的CST减少了虚假伪标签的影响,因此误报(图9(3.2))也比以前的方法(图9(1.2)(2.2))少得多。

5. 结论

本文提出了一种新的无监督三维目标精确检测方法——CPD框架。首先,我们开发了一种MFC方法来生成初始伪标签。然后,使用CSS评分构造CProto集。接下来,我们介绍了一种CBR方法来改进这些伪标签。最后,设计了一种CST来提高稀疏目标的检测精度。大量的实验验证了我们设计的有效性。值得注意的是,我们的无监督CPD方法首次超过了一些弱监督方法,证明了我们方法的先进性。

局限性。我们工作的一个值得注意的限制是,与车辆等更普遍的类别相比,少数类别(如骑自行车的人)的平均精度(AP)明显较低(表1)。这种差异很大程度上是由于数据集中这些少数类的实例很少。未来收集这些物体的努力可能是解决这一问题的一个有希望的途径。

补充材料

6. 方法详情

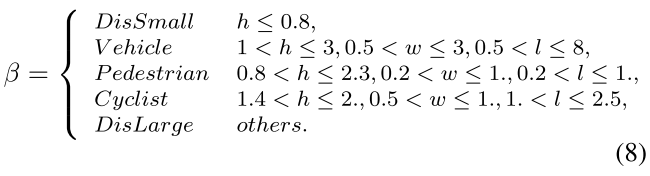

更多关于mfc的细节。在我们的主要论文3.1节中,我们介绍了用于初始标签生成的多帧聚类(MFC)。为了更直观的理解,我们在图10中提供了一个框架说明。这里我们介绍更多的后处理细节。正如我们在主要论文中提到的,我们基于人类常识预先定义了一组特定于类的大小阈值,将伪标签分类到不同的类别中。以WOD为例,我们预先定义了五个类别:‘Discard Small’, ‘Pedestrian’, ‘Cyclist’, ‘Vehicle’, and ‘Discard Large’。形式上,对于聚类盒bj,我们通过从阈值顺序匹配来确定类恒等式β:

式中l、w、h分别为bj的长、宽、高。“废弃大”盒子大多是树木和建筑物被直接移除。‘Discard Large’框包含潜在的前景对象和背景对象。然后,我们应用类别不可知跟踪将小背景对象与前景轨迹关联起来,并利用时间相干性增强对象大小的一致性。

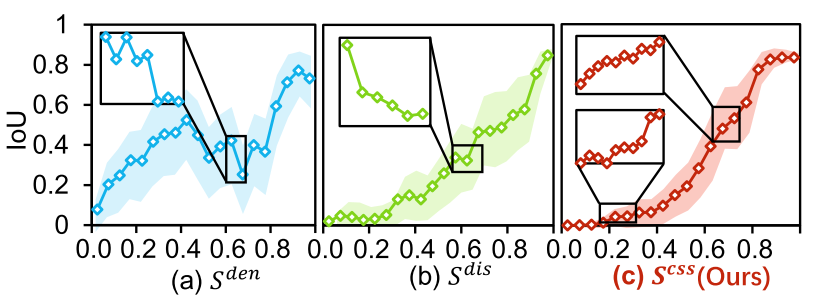

CSS评分的更多细节。在我们的主要论文3.2节中,我们介绍了CSS评分。为了更好地理解CSS评分如何接近IoU评分,我们在图11中给出了IoU评分曲线,其中我们展示了三种方法:密度评分(sden),距离评分(sdis)和CSS评分(scss)。直观上,好的评分应该与IoU评分保持一致。换句话说,随着分数的增加,所选择的伪标签与基础真值的借据应该更大。我们发现,随着IoU的增加,我们的CSS评分保持了最一致的增长。这里我们还提供了主论文Eq. 3中计算Size Similarity的模板盒的长度、宽度和高度:

{

'Vehicle': [5.06, 1.86, 1.49],

'Pedestrian': [1.0, 1.0, 2.0],

'Cyclist': [1.9, 0.85, 1.8]

}

7. 更多实验结果

更多可视化结果。为了更好地理解我们的方法是如何提高检测结果的,这里我们展示了更多的可视化结果。从图12中可以看出,由于基于cproto的设计,我们的方法(3.1-3.4)的识别和定位性能都比之前的方法(1.1-1.4,2.1-2.4)要好得多。

WOD验证集上的BEV AP和3D APH结果。一些完全监督的方法也报道了BEV AP L2和3D APH的性能。在这里,我们分别在表11和表12中给出了结果。我们的CPD在BEV AP L2和APH L2上都大大优于之前的MODEST和OYSTER,进一步证明了我们方法的有效性。